Здравствуйте читатели блога о продвижении сайтов webbomj.ru. Сегодня мы поговорим о контенте, а точнее о парсере сайтов. В прошлых статьях рубрики мы разбирали статью — проверка позиций сайта в поисковой системе.

План статьи:

Парсер сайтов — введение.

Многие web мастера гоняются за контентом для наполнения своих сайтов, некоторым нужен копипаст (статья — о копипасте и борьбы с плагиатом), другим уникальный (рерайт или копирайт, об уникальности текста писал тут и тут).

Раньше на создании низкокачественных сайтах можно было заработать деньги, например продажа ссылок на сателлитах приносил прибыль и сайты чувствовали себя хорошо.

Хорошо индексировались (проблем с индексацией сайта не было), хорошо раскупались ссылки, капали денежки на счет. Но поисковые системы боролись с такими сайтами и выдвигали все больше новых фильтров (о фильтрах Яндекс и фильтрах Google).

Сейчас, парсеры сайтов, используются больше для получения огромных баз информации, например с сайтов кампаний и т.д.

Рабочие парсеры сайтов.

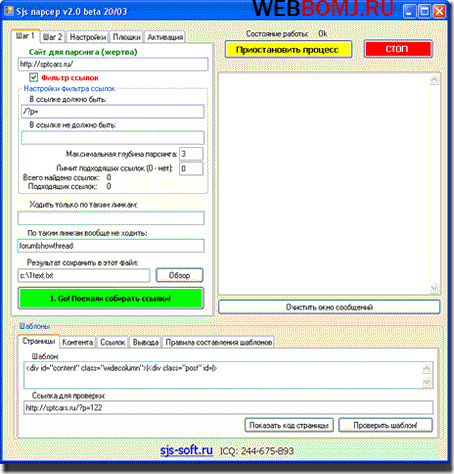

Парсер сайтов от SJS.

В 2010 году я писал о универсальном парсере контента SJS, я до сих пор пользуюсь этим парсером и получаю любой контент с любого сайта.

Данный парсер — НИГДЕ не продается, его можно найти в открытом доступе в интернете (достаточно поискать).

SJS является универсальным парсером, т.е. он не заточен под какой-то один вид сайтов (например сайты на WordPress, Joomla, DLE). В настройках достаточно написать шаблон парсинга и получить готовый контент по шаблону.

Работать с парсером, очень просто (всегда все просто, когда уже делал что-то):

- Настраиваете шаблон для парсинга ссылок.

- Парсите ссылки.

- Настраиваете шаблон для парсинга контента.

- Парсите контент.

Достаточно добавить контент в любую CMS (статья — Cms для сайта визитки) и у вас появился готовый сайт для продажи ссылок. Также можно спарсить, например базы всех фирм в городе, для чего либо.

Вот вам видео по пользованию данным парсером:

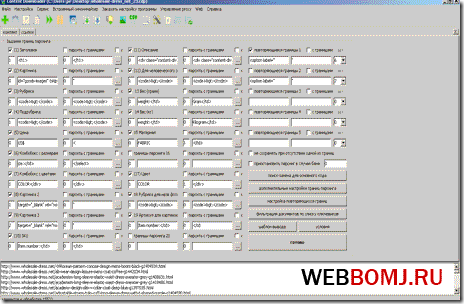

Парсер сайтов — Content Downloader.

В одно время был достаточно покупаемой программой. Является универсальным парсером контента. Делает все тоже самое, что и SJS парсер (я написал о нем выше), а именно:

- Сбор ссылок.

- Сбор картинок.

- Сбор текстовых статей.

- Парсинг с закрытых сайтов, требующих авторизации.

Поработать с официальной версией программы мне не доводилось, доводилось работать с ломанной версией. Программа, очень похожа на программу SJS, но все таки имеет ряд интересных функций (достаточно посмотреть на функцию парсинга с закрытых сайтов).

Парсер можно купить или найти в ломанном виде, достаточно поискать в поисковых системах.

Видео по работе с парсером сайтов:

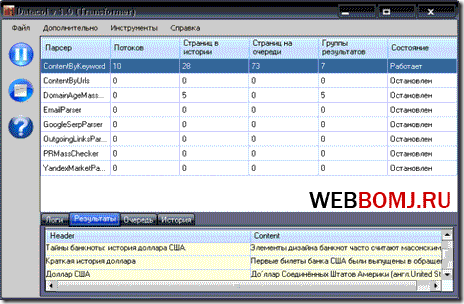

Парсер сайтов — Datacol.

Datcol — парсер контента по ключевым словам. Парсер является бесплатным и очень удобным для некоторых случаев

Datcol — парсер контента по ключевым словам. Парсер является бесплатным и очень удобным для некоторых случаев

Принцип работы парсера прост:

- Вводится ключевое слово.

- Парсится URL из выдачи Google по ключевому слову.

- Далее идет сбор контента по спарсенным URL.

Скачать и найти дополнительную информацию можно тут.

Также выкладываю видео, по работе с Datacol:

С этими тремя парсерами я работал и работаю, парсеры сайтов проверены мной лично и еще одной двумя тысячами web мастеров, они доказали свою работоспособность и необходимость.

Подскажите какой-нибудь парсер, а то я уже 3 штуки скачал, и все какие-то не рабочие(

SJS парсер на nulled.cc можно найти

Не нашел рабочий парсер контента SJS. Буду благодарен если отправите на почту

Еще упустили онлайн сервис для парсинга сайтов http://convextra.com

Умеет парсить каталоги товаров, объявления, да и вообще все что угодно без привязки к верстке и каких-либо настроек

Зашел на Ваш блог с обзора на другом блоге. Наткнулся на эти парсеры, жаль сейчас живу за городом и боюсь, что скорости модемного подключения не хватит для их работы. Но инфа полезна, даже более чем!

Здравствуйте. Скажите пожалуйста, а как добавить готовый контент в Joomla 2.5?

Спасибо за полезную инфу. Можно ли при помощи SJS заполнять доп поля при добавлении на DLE? Или для этого есть другой инструмент?

Там можно оформить стиль вывода из программы, дле не знаю. Попробуйте COntent Downloader. В сети уже лежит бесплатно.

А может SJS парсить файлы лежащие на компьютере? Может вы знаете другую прогу для парсинга файлов на компе?

Content Downloader наверное умеет. Пользуюсь им только для парсинга информации со страниц.

Парсер это умеет делать.

Парсер это в первую очередь быстрое получения текстового кластера информации.

Андрей, а какой толк от этих парсеров?

Ведь сайты, склепанные на них вылетают из индекса ПС за 1-2 месяца. Не факт, что такой сайт хостинг и домен успеет окупить.

Я использую синдикатор Ночной Бдун. Парсинг в нем бесплатен, настраивается все проще пареной репы.

Теперь по монеты. Платно умеет еще и публиковать на автомате причем в любые движки. Автор дает заработать на партнерке.

ну а непорядочные сами найдут, все что им захочется, надо полагать ;-D.

Здравствуйте. Мне нужен parser для наполнения товаров в интернет магазин, источники преимущественно с сайтов на английском языке. Какой лучше для этих дел подойдет парсер? А то я растерялся)

Проще всего взять Content Downloader

а можно парсером проверить не рабочее видео на сайте, например на mifilon.ru. Проверка parser

Привет, а не подскажите парсер для сбора информации об объявлениях на заданную тематику для заполнения доски объявлений? Спасибо за помощь:)

… но тексты, я так понял всё же лучше дорабатывать самому…